Selon une étude du cabinet Mckinsey, la moitié des activités professionnelles actuelles pourraient être automatisées d’ici 2030 à 2060. Le rapport prévoit également que l’impact de l’intelligence artificielle générative pourrait avoir un impact de 4,4 milliards de dollars sur l’économie mondiale. La promesse d’un tel bouleversement a enclenché une véritable course à l’armement technologique. Les investissements économiques et stratégies se croisent et se combinent dans le but d’obtenir un avantage compétitif, essentiel pour les organisations ou les pays leaders qui souhaitent dominer leurs marchés.

Entre enjeux géopolitiques et investissements stratégiques, qui façonnent l’avenir de l’IA et comment se redéfinit le paysage économique et politique de demain ?

I. Course à l’Innovation en IA – Décryptage des investissements en 2023

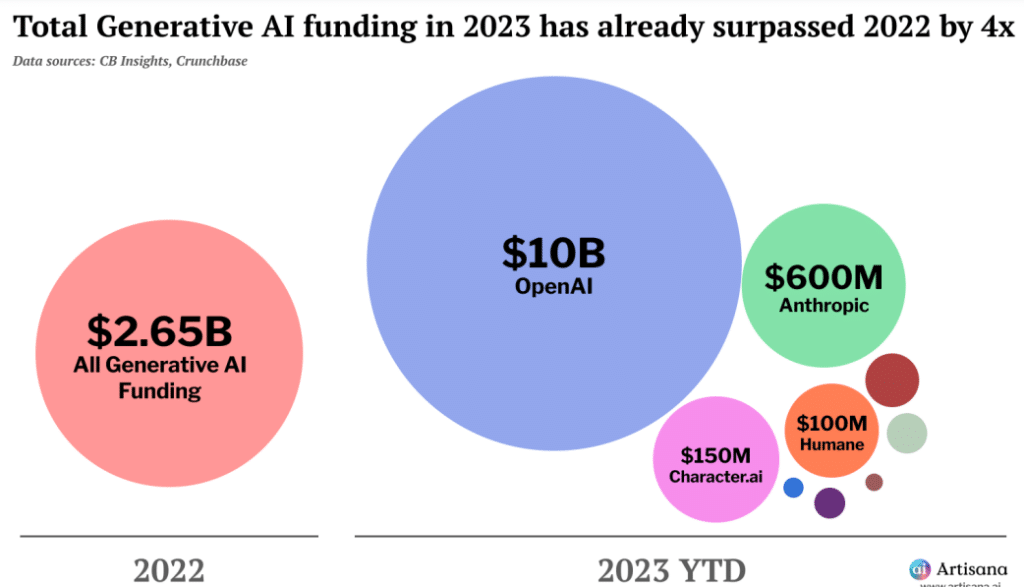

En 2023, les investissements en IA ont quadruplé par rapport à l’année précédente. Depuis la sortie de ChatGPT, les annonces de levées de fonds se sont succédé dans une véritable cacophonie médiatique. Voici un tour d’horizon des principaux acteurs qui financent l’IA et pourquoi ce n’est pas anodin.

1) Les Géants de la Tech américains, poumon de l’investissement en IA

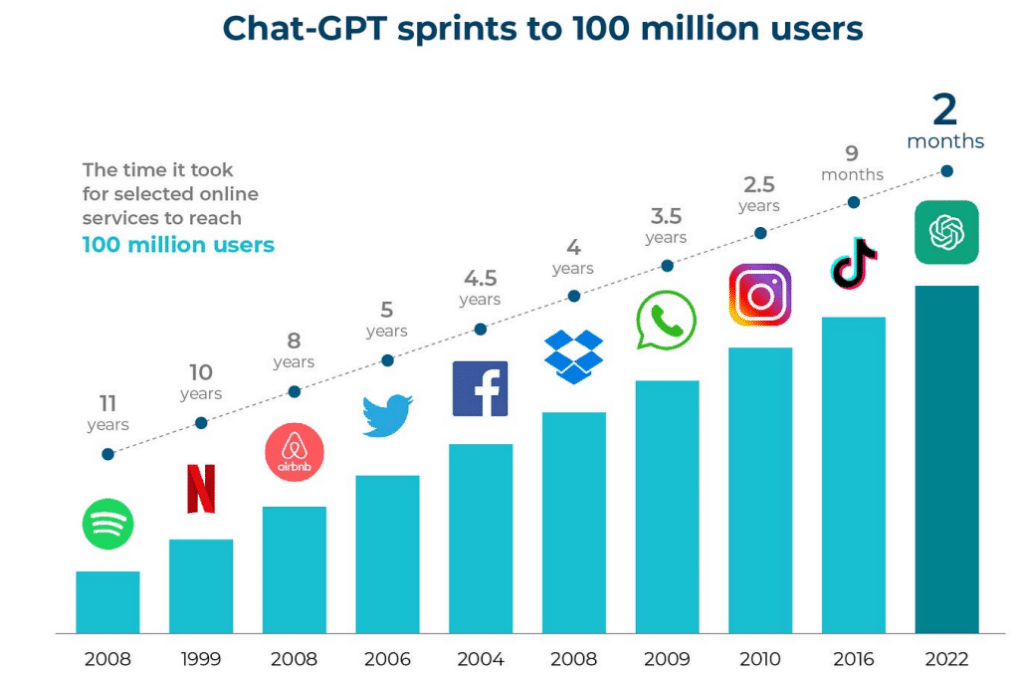

Fin 2022, ChatGPT établissait un record de vitesse d’acquisition d’utilisateurs en atteignant 100 millions d’utilisateurs en moins de deux mois, et ainsi commençait la hype de l’IA générative. Cette démocratisation, combinée à des prédictions de croissance faramineuses, a attiré les investisseurs, mais cela n’explique qu’en partie l’envolée des levées de fonds pour les startups IA que nous avons connu en 2023.

En effet, ces technologies ont des besoins financiers sans précédent. Le développement de modèles avancés comme GPT-4 engendre d’importants coûts pour la collecte de données et l’entraînement des algorithmes. L’infrastructure et la gestion de ces grands volumes de données sont également nettement plus coûteuses comparées aux applications SaaS, dont les coûts marginaux sont quasi nuls. À titre d’exemple, Open AI dépenserait près de 700 000$ chaque jour pour faire fonctionner ChatGPT. Cette nouvelle génération de startup est donc aussi prometteuse qu’elle n’est onéreuse.

Qui peut financer de tels investissements ?

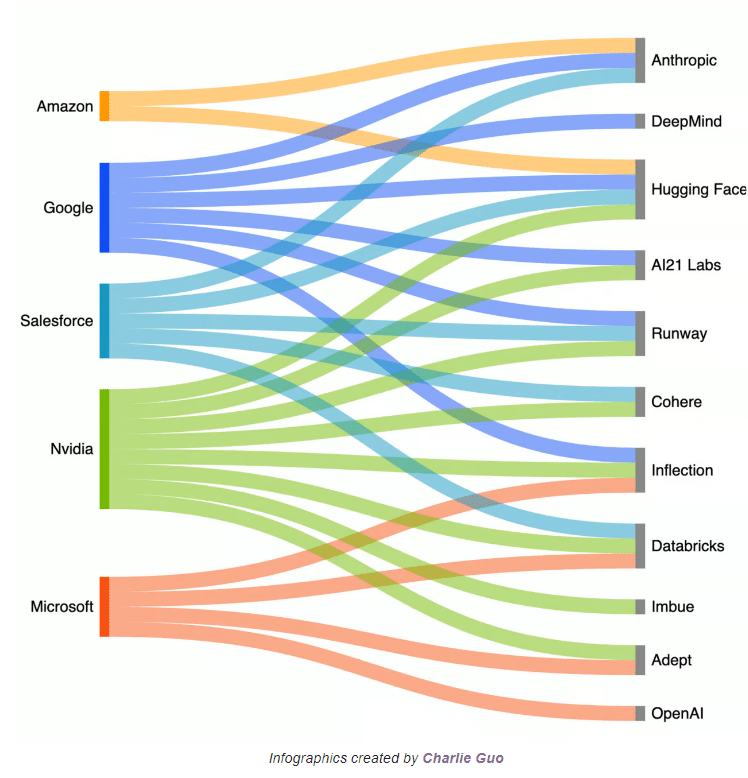

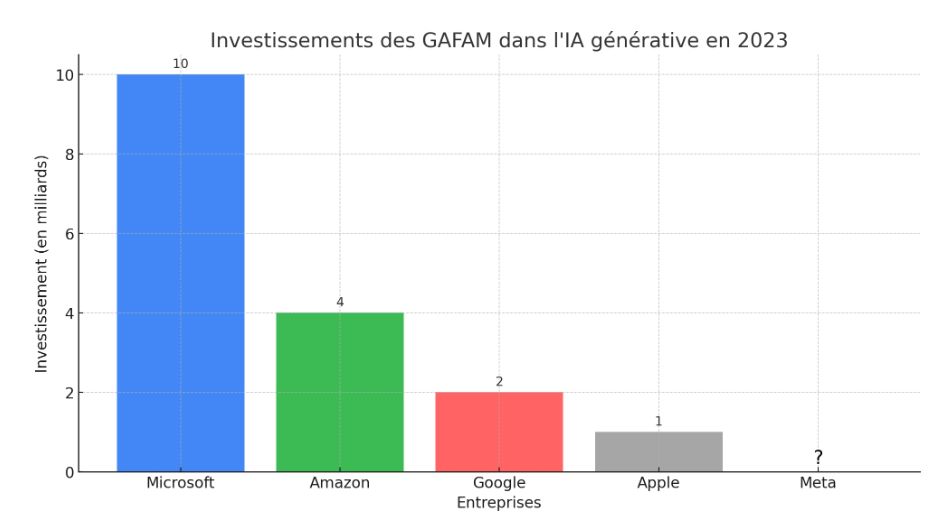

Grâce à leurs ressources financières considérables, leur compréhension approfondie des enjeux et surtout leur désir de rester en tête de l’innovation, les géants de la tech ont successivement réalisé des investissements époustouflants pour remporter la course à l’IA. Le graphique ci-dessous nous montre la magnitude et la variété d’investissements réalisés par les principaux acteurs de la tech au cours des 12 derniers mois.

En mars 2023, Microsoft a frappé très fort en validant un investissement record de 10 milliards d’euros dans Open AI, la société derrière ChatGPT. Cette somme colossale pourrait être le prix à payer pour dépasser Google et ainsi devenir le tout nouveau champion de la Tech. Si les sommes peuvent sembler astronomiques, l’enjeu est majeur : Microsoft et ses principaux concurrents, commercialisent toute une suite de services auprès de leurs clients (service de messagerie, espaces Cloud, suites informatiques, plateformes média, etc.). L’intégration de l’IA dans leurs offres pourrait avoir un impact considérable sur leurs ventes et leur positionnement sur le marché.

En septembre 2023, Amazon investi à son tour en injectant 4 milliards dans la startup américaine Anthropic. Fin octobre, Google suit également et investit 2 milliards de dollars dans la startup. Fondée en 2021 par des anciens salariés d’Open AI, Anthropic a développé sa propre IA baptisée Claude et vise à concurrencer Microsoft. C’est la première fois que deux GAFAM investissent une somme aussi importante dans le même acteur. Amazon et Google vont ainsi commercialiser tous deux la solution au sein de leurs plateformes respectives. Le fait que les trois plus gros investisseurs soient tous des fournisseurs de solution Cloud (Microsoft avec Azure, Google avec Google Cloud et Amazon avec AWS) est loin d’être anodin. Les startups d’IA, ayant d’importants besoins en infrastructures de données, profiteront des espaces de stockage offerts par les GAFAM. En retour, ces derniers bénéficieront d’un accès privilégié à ces solutions, leur permettant de rester compétitifs en intégrant l’IA dans leurs offres de services.

De son côté, Apple, qui s’est fait plus discret jusqu’ici, a privilégié une approche de croissance organique, mais à tout de même alloué 1 milliard de dollars à la recherche pour développer son propre modèle d’IA prénommé Ferret. Ce modèle aura la particularité d’être multimodal (étant capable d’analyser aussi bien des images ou vidéo que du texte) à l’instar de GEMINI déployé par Google fin 2023.

| Entreprises | LLM (IA) |

|---|---|

| Gemini | |

| Microsoft | GPT-4 (OpenAI) |

| Amazon | Anthropic |

| Meta | Llama, Llama-2 |

| Apple | Feret |

| X | Grok |

Dans cette bataille féroce à laquelle se livrent les géants du numérique, Meta choisi de miser sur l’Open Source. Après avoir loupé le virage du Metaverse et fini par totalement suspendre les recherches en la matière. L’entreprise se positionne comme le leader de l’Open Source, choisissant ainsi de rendre disponible ses derniers modèles d’IA Llama et Llama-2 en libre accès – de façon totalement gratuite. Cette stratégie est en train de s’avérer gagnante puisqu’elle permet de gêner ses concurrents qui commercialisent des solutions similaires et elle est bien partie pour s’imposer comme une des grandes tendances de l’année.

Meta va encore plus loin, en annonçant le 05 décembre dernier, la création d’une alliance avec IBM pour favoriser l’expansion de l’Open Source à travers le monde. Cette organisation regroupe plus de 50 entreprises et universités et a pour objectif de favoriser l’emergence des IA Open Source face aux modèles propriétaires développés par ses concurrents comme Open AI ou Google.

Lors d’une ruée vers l’or, ce sont souvent les vendeurs de pelles qui profitent le plus.

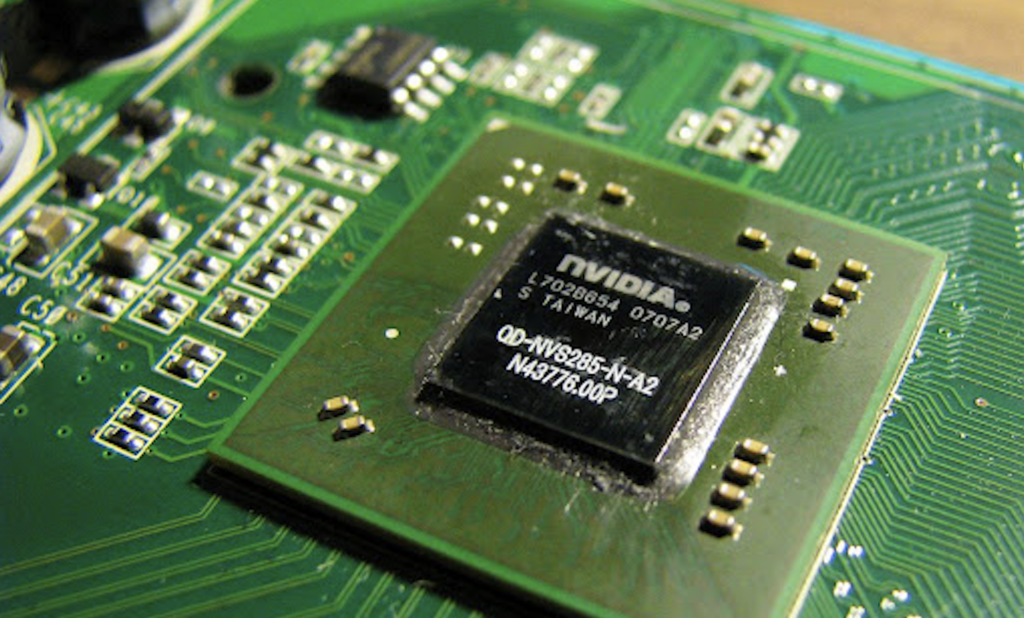

Nvidia, le fabricant des puces Graphics Processing Unit (GPU ou unité de traitement graphique en français) cruciales pour le développement de l’IA a rejoint un club sélectif incluant Apple, Microsoft, Google, Amazon, avec une valorisation boursière dépassant les 1.000 milliards de dollars. La firme américaine a ainsi doublé son chiffre d’affaire et multiplié par 9 ses bénéfices pour atteindre les 6,2 milliards de dollars.

Nvidia récolte les bénéfices de la vision de son CEO et cofondateur, Jensen Huang, qui a investi dans l’IA dès 2012. Dans les tâches d’IA, Huang a développé une nouvelle gamme de processeurs et le langage de programmation Cuda, spécialisé en IA. Cette initiative a établi Nvidia comme un titan de la technologie et comme un acteur indispensable du marché sur qui il faudra compter dans les prochaines années.

Après une année ahurissante en matière d’investissements en IA, 2024 devrait être celle de l’intégration et du déploiement de ses solutions, notamment au sein des entreprises qui, malgré un intérêt grandissant n’ont pour le moment mis au point que très peu de cas d’usages.

2) D’ici 2049, la Chine vise à dépasser les États-Unis afin de se positionner en tant que leader mondial dans le domaine de l’intelligence artificielle.

Nombre de Pays comptent sur l’IA pour se faire une place dans le nouvel ordre mondial. Parmi eux, la Chine, est sans doute l’exemple le plus spectaculaire.

Dès 2017, la Chine dévoilait un budget faramineux : 20 milliards de dollars par an, puis 59 milliards à l’horizon 2025 (contre 900 millions d’euros pour la France par exemple). L’ambition est nette : établir la Chine comme le leader indiscutable de l’IA.

Cet engouement a des fondements éminemment géopolitiques: La Chine compte bien capitaliser sur l’IA afin de surpasser les Américains et ainsi devenir le premier leader économique.

Baidu, Alibaba et Huawei : Les géants technologiques Chinois en avant.

Dès 2013, Baidu a mis en place un laboratoire de recherches internes, l’Institute of Deep Learning, témoin des ambitions extrêmement étendues de ce groupe qui dirige aujourd’hui plusieurs autres laboratoires, dont un avant-poste employant 200 personnes dans la Silicon Valley.

Le 7 juillet, lors de la World Artificial Intelligence Conference 2023 à Shanghaï, Alibaba Cloud a présenté Tongyi Wanxiang. Cette IA offre la possibilité aux utilisateurs de formuler des demandes en anglais et en chinois, permettant ainsi la création d’images dans une variété de styles, y compris des photos, des dessins animés et des esquisses.

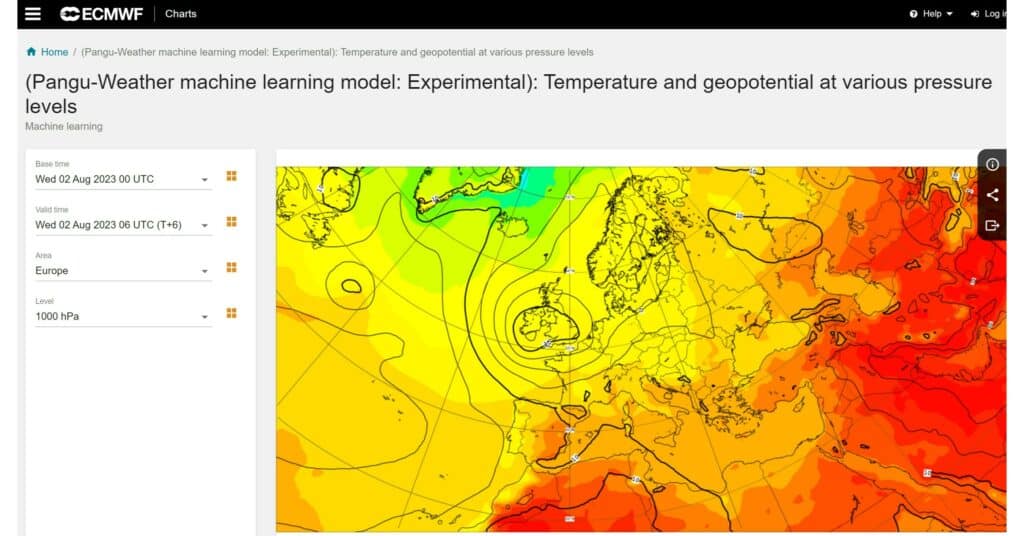

Huawei a introduit Pangu-Weather, le premier modèle de prévision utilisant l’IA à faire preuve d’une plus grande précision que les méthodes numériques traditionnelles de prévision météorologique. Le modèle permet de multiplier par 10 000 la vitesse de prédiction, réduisant le temps de prévision météorologique mondiale à quelques secondes seulement. Ces développements témoignent de la volonté des entreprises chinoises de jouer un rôle de premier plan dans l’IA générative et industrielle.

Un système de surveillance des masses omniprésent et auto-géré

Ces avancées technologiques nourrissent également l’idéologie du régime qui vise à contrôler et réguler ses concitoyens au maximum. Pour cela, l’IA se révèle être un outil redoutable.

Le crédit social, qui vise à attribuer, à chaque citoyen (chinois ou non) un crédit en fonction de leur comportement est déjà en place dans 43 municipalités du pays. Ce système aboutit à un classement attribuant des droits et récompenses, ou imposant des sanctions telles que des restrictions administratives et médicales, l’accès limité à certains emplois publics, ou même le droit ou l’interdiction d’acheter des billets d’avion, parmi d’autres exemples.

Un tel système rend indispensable l’IA, pour collecter, traiter et activer des centaines de millions de données en temps réel. Le Parti état entend non seulement déléguer son rôle de contrôle aux individus eux-mêmes en misant sur l’interconnexion des individus pour améliorer son scoring, mais également exporter son dispositif de contrôle à l’étranger. Huawei qui est le leader en la matière a déjà signé des contrats avec une cinquantaine d’état dont l’Italie. L’Algérie a intégré, parmi d’autres technologies, des dispositifs de reconnaissance faciale développés par la firme Chinoise. Dans un contexte où les nations s’efforcent d’accroître leurs capacités de sécurité, l’avancée technologique de la Chine suscite un intérêt croissant.

3) La France émerge comme un des leaders Européens

« Nous sommes en bonne position en Europe continentale, mais nous sommes un peu décrochés par les Britanniques, tandis que les Etats-Unis d’Amérique et la Chine vont beaucoup plus vite que nous », Ce sont les mots du président Français lors du salon Vivatech en Juin dernier.

Ainsi, la France a annoncé un dispositif de 900 millions d’euros avec un objectif clair: créer plus de champions européens de l’IA.

Le premier champion a émergé cette année et il s’agit de Mistral AI, une start-up française fondée par des experts formés à Polytechnique et à l’ENS. Avec une levée de fonds de 385 millions d’euros en décembre 2023, valorisée à 2 milliards de dollars, Mistral AI attire l’attention d’investisseurs de premier plan tels que Salesforce et Nvidia, démontrant l’intérêt croissant pour l’IA en Europe.

Dans un secteur où les États-Unis et la Chine prédominent, le projet Kyutai, porté par Xavier Niel, Rodolphe Saadé et Eric Schmidt, vise à faire de la France un acteur majeur de l’IA.

Doté de 300 millions d’euros, ce laboratoire indépendant à but non lucratif a pour objectif de développer et promouvoir l’IA Open Source. Il vise à développer des modèles capables de générer des contenus textuels, audio et vidéo, et promet de partager ses recherches en accès libre. Avec un soutien fort de l’exécutif français, notamment d’Emmanuel Macron, Kyutai est présenté comme un acteur clé pour la souveraineté technologique de la France et de l’Europe. Le laboratoire bénéficiera également de ressources rares, comme l’accès à Nabuchodonosor, un supercalculateur puissant dédié à l’IA.

L’innovation en IA ne se limite pas à la France. La région abrite également des acteurs clés tels que DeepMind, une société britannique de recherche en IA fondée en 2010 et rachetée en 2014 par Google.

II. La régulation, une course effrénée pour imposer sa vision à travers le monde

De la même manière que la course aux investissements technologiques, il existe une compétition acharnée entre les régulateurs à l’échelle internationale. Le premier à établir un cadre réglementaire efficace pour l’IA peut non seulement orienter le développement futur de cette technologie, mais aussi obtenir un avantage stratégique considérable. Cette urgence de réguler influence les stratégies des états et redéfinit les enjeux globaux de l’IA. Nous explorerons comment cette dynamique modifie le paysage technologique et stratégique mondial.

1) L’Europe Pionnière en Régulation de l’IA avec l’AI Act

Le 8 décembre dernier, les Etats membres et le Parlement européen sont parvenus à un accord, établissant pour la première fois un cadre réglementaire autour de l’utilisation de l’IA. L’enjeu est de taille puisque cela permettrait de positionner l’Europe comme leader mondial dans la définition des normes éthiques et de sécurité pour la technologie IA.

L’objectif principal de l’AI Act est de s’assurer que les IA mis sur le marché européen soient à la fois sûrs et respectueux des droits fondamentaux des citoyens. Par ailleurs, cette législation vise à garantir une sécurité juridique pour stimuler l’investissement et l’innovation dans le domaine de l’IA.

C’est un point qui a longuement été débattu, tout l’enjeu étant de trouver l’équilibre entre sécurité et innovation afin de ne pas freiner les champions européens dans leurs développement

Le texte vise également à faciliter le développement d’un marché unique pour des applications d’IA légales, sûres et fiables, afin de prévenir la fragmentation du marché.

Les entreprises visées par cette réglementation incluent toutes les entreprises qui distribuent ou proposent des systèmes d’IA au sein de l’Union Européenne, qu’ils soient basés dans l’Union ou dans des pays tiers.

C’est un point clé, car les entreprises étrangères ne pourront pas commercialiser d’IA en Europe, un marché stratégique, sans respecter l’IA ACT, et cela démontre le poids des régulateurs dans les enjeux économiques.

1,5% à 7% du chiffre d’affaires annuel mondial ou 7,5 à 35 millions d’euros, c’est l’amende qui pourrait être donnée suivant les violations constatées.

Afin de mieux comprendre l’impact d’une telle régulation, j’ai pu m’entretenir avec Clara Ripault, avocate et experte IA:

- Question: Pourquoi les régulateurs se livrent ils une telle course à la régulation ?

Clara: Depuis 2018, l’UE s’est lancée dans la régulation de l’IA, notamment pour des raisons économique et politique. Appliquer une régulation unique dans l’UE permettrait de favoriser l’émergence de leaders européens en IA. Le marché n’étant pas juridiquement segmenté, les entreprises peuvent facilement commercialiser leurs IA dans plusieurs Etats européens. L’émergence d’IA made in EU permettrait de se détacher des entreprises américaines et impacterait positivement la souveraineté et l’indépendance de l’UE.

Depuis quelques mois, en réaction aux GenAI, d’autres pays se lancent dans la course. Elles ont été développées en flirtant avec le droit ce qui conduit à des procès en contrefaçon aux USA et des plaintes privacy en Europe, ainsi qu’à des risques importants pour les entreprises (perte de confidentialité) et pour les citoyens (désinformation, arnaque). Il devient nécessaire d’encadrer l’IA pour limiter ces risques et apporter de la sécurité aux utilisateurs.

Etre le premier à réguler l’IA permettrait aussi de mettre en avant ses valeurs, par exemple l’AI Act le fait en interdisant la notation sociale à la chinoise.

- Question: En quoi l’AI ACT est un acte fondateur ?

Clara: Il est fondateur car il devrait être le premier à réguler l’IA. Il influencerait ainsi les autres Etats et le comportement des entreprises étrangères visant le marché européen. Devant développer des IA conformes, elles intégreraient ces contraintes à leurs pratiques.

Il est fondateur économiquement car il favorise l’émergence d’un marche européen de l’IA. En établissant un cadre juridique clair, il apporte de la visibilité et encourage les entreprises à investir dans le développement et l’utilisation d’IA. La mise en place de normes de sécurité donne confiance aux consommateurs et favorise leur adoption de l’IA.

Il est aussi fondateur juridiquement car il ouvre la voie à d’autres régulations européennes sur l’IA. Notamment une directive concernant la responsabilité civile, c’est-à-dire qui indemnise la victime lors de dommages causés par une IA.

- Question: Quelles sont les tendances qui se dessinent en terme de régulation ?

Clara: En plus de l’économie, l’impact du régulateur est important sur la sécurité. Il protège les utilisateurs en interdisant certains usages de l’IA et en encadrant les autres.

Dans les tendances qui se dessinent, je pense qu’on se dirige vers un élargissement de la prise en considération de l’éthique lors du développement et du déploiement des IA. Je pense notamment aux principes de transparence, de loyauté et de responsabilité des IA. Concrètement, ces principes permettent aux utilisateurs d’être prévenus quand ils interagissent avec une IA (transparence) et d’avoir une IA qui réalise exclusivement les tâches pour lesquelles elle est officiellement mise sur le marché (loyauté). Ils sont indispensables à une adoption confiante et apaisée de l’IA.

2) Après une initiative timide, Le congrès américain passe à l’action

En aout dernier Le président Biden a signé un décret ambitieux pour réguler l’IA, avec un accent sur la sécurité, la protection de la vie privée et la gestion des préjugés, notamment dans les systèmes de recrutement automatisés.

“Pour réaliser les promesses de l’IA et éviter les risques, nous devons gouverner cette technologie. Il n’y a pas d’autre solution (…) : elle doit être encadrée“.

Bien qu’ambitieux, ce décret n’avait peu d’impact sur les entreprises car il ne stipulait que des recommandations.

Le congrès américain concrétise l’AI Fondation Model Transparency Act

Fin décembre 2023, quelques semaines après l’annonce de l’AI Act, le congrès américain a annoncé un projet de loi visant à obliger les entreprises d’IA à divulguer les données d’entraînement protégées par le droit d’auteur. Ce projet a pour but de clarifier l’utilisation de données protégées par le droit d’auteur dans l’entraînement des modèles d’IA.

“L’IA offre des possibilités incroyables pour notre pays, mais elle présente aussi des dangers. La transparence sur la manière dont les modèles d’IA sont formés et sur les données utilisées pour les former est essentielle pour les consommateurs et les décideurs politiques”.

Pour renforcer cette transparence, les entreprises devront dorénavant déclarer explicitement les sources de leurs données d’entraînement et expliquer comment ces données sont gérées. Elles devront également décrire les limites et les risques potentiels de leurs modèles, et montrer comment ces derniers s’alignent sur les cadres de gestion des risques de l’IA, notamment ceux prévus par le NIST (National Institut of Standard Technology). De plus, les informations concernant la puissance de calcul nécessaire à l’entraînement et au fonctionnement des modèles seront requises. Le projet de loi exige également que les développeurs d’IA mettent en place des mécanismes de sécurité, pour prévenir la diffusion d’informations inexactes ou nuisibles, particulièrement dans des domaines sensibles tels que la santé, la cybersécurité, les élections, et d’autres secteurs impactant directement le public.

Le projet de loi de Mmes Eshoo et Beyer complète le décret sur l’IA de l’administration Biden, qui contribue à établir des normes de déclaration pour les modèles d’IA. Si la loi sur la transparence des modèles de la Fondation pour l’IA est adoptée, les exigences en matière de transparence des données de formation deviendront une règle fédérale.

Focus sur le débat des modèles Open Sources

L’univers de l’intelligence artificielle est marqué par une distinction fondamentale entre les modèles open source et les modèles propriétaires. Les initiatives open source, comme le projet LLaMA de Meta, stimulent l’innovation collaborative en rendant les modèles d’IA accessibles à tous. Cela favorise la contribution de divers acteurs, mais soulève des problèmes de sécurité et de contrôle, avec un risque accru d’utilisations malveillantes ou non éthiques.

En contraste, les modèles propriétaires, à l’exemple de ceux développés par Google et OpenAI, visent à garantir la qualité et la sécurité. Leur contrôle strict sur l’accès et l’utilisation de leurs IA permet une gestion des risques plus efficace et protège la propriété intellectuelle. Cependant, cette approche peut limiter l’innovation en restreignant la collaboration et en gardant un contrôle exclusif sur certaines technologies clés.

Google et OpenAI, après avoir initialement opté pour l’open source, ont récemment limité le partage de leurs recherches. Malgré leur soutien affiché à l’open source, ils sont confrontés à un choix stratégique : conserver leurs avancées en IA pour ne pas avantager leurs concurrents ou suivre l’exemple de Meta en publiant ouvertement, pour éviter d’être dépassés par l’open source et devenir le standard pour les développeurs, à l’image d’Android de Google.

La régulation du partage des modèles d’IA en open source est au cœur d’un débat crucial.

D’un côté, les défenseurs de l’open source arguent que cela démocratise l’accès à l’IA, stimule son développement, et prévient le monopole de certaines entreprises sur ces technologies, tout en assurant une transparence sur leur fonctionnement et les biais potentiels. Ils voient dans l’open source un levier positif pour le marché.

De l’autre côté, les opposants à l’open source soulignent les risques liés à la disponibilité de ces modèles, notamment leur utilisation malveillante par des hackers. Ils pointent du doigt la possibilité de renforcer des monopoles économiques et l’usage de l’IA non transparente pour des stratégies de manipulation économique.

Aux États-Unis, les discussions au Congrès sont au cours et plusieurs entreprises ont été entendus au cours d’interviews préliminaires, comme se fut le cas de Sam Altman il y a quelques semaines, mais rien a encore été acté.

3) La régulation Chinoise: Le subtile équilibre entre Contrôle et Innovation

En fin d’année l’Etat Chinois a émis 24 directives qui imposent aux entreprises qui commercialisent des IA, un cadre réglementaire rigoureux, avec des exigences telles que l’enregistrement obligatoire des services d’IA et une revue de sécurité préalable à leur lancement. Ce niveau de surveillance, impliquant sept agences gouvernementales, souligne une volonté ferme de l’État chinois de contrôler et de réguler ce secteur en pleine expansion.

La différence entre l’approche Chinoise et l’approche européenne et américaine est particulièrement frappante. La Chine semble prendre une voie beaucoup plus interventionniste, notamment en comparaison avec les États-Unis, où la législation sur l’IA est encore en phase de gestation.

Les réglementations chinoises comprennent des directives spécifiques telles que l’obligation d’étiqueter clairement le contenu généré par l’intelligence artificielle, une mesure destinée à éviter la confusion ou la tromperie en permettant au public de distinguer entre les contenus authentiques et ceux créés artificiellement. Cette approche met l’accent sur la transparence et la fiabilité dans l’utilisation des technologies d’IA. L’exigence pour les entreprises d’utiliser des données “légitimes” pour entraîner leurs modèles et de divulguer ces données aux régulateurs montre une tentative de balancer innovation et contrôle étatique.

Il est également intéressant de voir comment la Chine prépare le terrain depuis des années, avec le Conseil d’État publiant une feuille de route pour l’IA dès 2017. Cette anticipation stratégique souligne l’importance accordée à l’IA en tant que domaine clé pour l’avenir du pays.

Tous les outils et contenus doivent également adhérer aux valeurs socialistes, avec une responsabilité accrue pour les développeurs dans la détection et la correction des contenus illégaux.

Les valeurs du partis s’exprime également dans la censure.

Lorsqu’un utilisateur tente de générer une image du président de la République populaire de Chine, Xi Jinping, un avertissement s’affiche : “Cette expression est interdite. Toute tentative de contournement de ce filtre pour violer nos règles peut conduire à la suppression de votre accès”. Cette restriction a suscité de vives réactions d’indignement. Le fondateur de Midjourney quant à lui, estime qu’il est préférable de fournir aux utilisateur un service, qui ne permet pas la satire politique plutôt que ne pas fournir de service du tout.

Une alliance transnationale pour encadrer l’IA

La Déclaration de Bletchley, signée lors du “AI Safety Summit 2023” par 28 pays, y compris le Royaume-Uni, les États-Unis, l’UE, l’Australie et la Chine, marque un tournant crucial dans la reconnaissance des risques associés à l’intelligence artificielle. Cette déclaration, issue d’un sommet organisé par le gouvernement britannique, souligne que l’IA, tout en offrant d’énormes opportunités pour améliorer le bien-être humain, présente également des risques importants, notamment dans des domaines critiques tels que la cybersécurité, la biotechnologie et la propagation de la désinformation.

L’aspect le plus frappant de cette déclaration est l’accent mis sur l’importance d’une gestion coopérative internationale de ces risques. En reconnaissant que les défis posés par l’IA sont intrinsèquement internationaux, les signataires s’engagent à collaborer pour assurer une IA centrée sur l’humain, fiable et responsable. Ils prévoient de se concentrer sur l’identification commune des risques de sécurité de l’IA et sur l’élaboration de politiques nationales adaptées à ces risques, tout en tenant compte des différences juridiques et situationnelles entre les pays.

Conclusion

Si 2023 était l’année de l’ébullition, 2024, sera certainement celle de la structuration, entre enjeux géopolitiques et économiques, une nouvelle carte du monde se dessine. Les GAFAMs, avec leurs moyens d’ampleur, luttent avec acharnement pour conserver leur place. Les nouveaux entrants, comme Mistral AI, poussé et chouchouter par les régulateurs Européens ont la capacité d’émerger comme un nouvel acteur important, mais la lutte sera

Une chose est sûre, la bataille de l’IA ne fait que commencer, et à travers elle s’affrontent des Géants, Pays et entreprises qui comptent bien capitaliser sur cette nouvelle économique pour étendre leur influence à travers le monde.

A ce stade, l’Europe à probablement pris une longueur d’avance sur le plan de la régulation, mais les moyens économiques employés en Chine ou en Europe sont bien plus conséquent. Il sera donc intéressant de voir à quel point l’Europe parvient à imposer ses normes à travers le monde. D’autant plus que la mise en place des régulations prennent du temps, nous avons pu le constater avec la RGPD, la loi sur les données qui a mis plus de 4 ans à être totalement mis en place.

D’ici là, nous pouvons nous attendre à de multiples retournements de situation, et plusieurs questions restent en suspens:

La Chine parviendra-t-elle à s’imposer comme le leader mondial d’ici 2049 ?

L’open Source s’imposera-t-il comme le modèle principal de l’IA ?

Les GAFAMs vont-ils se faire doubler par de nouveaux entrants ?